How ethical is Artificial Intelligence

Sukant Khurana

زنی مدت زمان کوتاهی پس از مرگ شریک زندگی خود متوجه بارداریاش میشود. او که قادر به کنار آمدن با غم و اندوه خود نیست، یک نسخهی رباتیک از او را سفارش میدهد. این نسخه به طرز شگفتانگیزی مانند شریک سابقش شوخطبع است. حتی از برخی جهات از او هم بهتر عمل میکند. با این حال، نمیتواند همیشه احساسات صمیمی این زن را درک کند. زندگی مشترک آنها به یک آشفتگی بزرگ تبدیل میشود.

متن فوق خلاصهای بود از قسمت «الان برمیگردم» سریال Black Mirror ــ یک سریال تلویزیونیِ علمی تخیلی که به طرز عجیبی علاقهی بشریت به فناوری را به تصویر میکشد. بیشتر قسمتها در زمان حال نیز نمود جایگزین دارند. برخی از تصاویر مربوط به مسائل معاصری هستند که ما در زمینهی هوش مصنوعی (AI) با آن روبرو هستیم.

باید بپذیریم که تجزیهوتحلیلِ تاثیرات هوش مصنوعی و اینکه چگونه میتواند آیندهی ما را شکل دهد، ضروری است.

در نگاه کلی، هوش مصنوعی یعنی الگوریتمها و مدلهایی که هدفشان تفکر، ادراک و عمل است. این ایده قرنها برای بشریت جذاب بوده، اما شروع واقعی هوش مصنوعی از تابستان 1956 در کالج دارتموث ایالات متحده رقم خورده است. تیمی متشکل از 10 دانشمند برجسته ــ مشتاق مدلسازی هوش بیولوژیک ــ برای یک پروژهی تابستانی 6 هفتهای تشکیل جلسه دادند و پایههای هوش مصنوعی را بنا نهادند. این تلاش بر اساس این حدس بود که «در اصل میتوان هوش را به قدری دقیق توصیف کرد که یک ماشین بتواند آن را شبیهسازی کند».

در شش دههی بعد از آن شروع گستاخانه، حوزهی هوش مصنوعی دورههایی از هیاهو و انتظارات بالا را با شکست و ناامیدی پشت سر گذاشته است.

نیک بوستروم، Superintelligence (2014)

در حالی که هدف اولیهی هوش مصنوعی درک هوش بود، اما اکنون میتوان گفت که راه درازی را پیموده است که هم موجب تحسین و هم ایجاد دلهره شده است. کسانی که آن را ترویج میکنند معتقدند که «به تلاش انسان کمک میکند» (مانند هر فناوری دیگری)، در مقابل افراد دیگر فکر میکنند که این عرصه مشابه میدان مینی از تعهدات اخلاقی و رفتاری است که کاملاً درک نشده است.

بیکاری و هوش مصنوعی

بر طبق تخمین دانشگاه آکسفورد در سال 2013 بیش از 47 درصد از کل مشاغل ایالات متحده تا دو دههی آینده خودکار خواهند شد. در کشورهای در حال توسعه، این برآوردها میتواند بیش از 70 درصد باشد. مطالعهی دیگری گزارش میدهد که بیش از 60 درصد از مردم بریتانیا احساس میکنند که هوش مصنوعی مشاغل آنها را خواهد دزدید. بیکاری افراد بدونشک مهمترین نقطه ضعف هوش مصنوعی است. نیازهای روزافزون به دقت، کارایی و صرفهجویی، صنایع را وادار به خودکارسازی ها و پایان دادن به مشاغل سنتی میکند. در بسیاری از موارد، این مسئله با اعتراضات و اعتصابات شدیدی مواجه میشود که حتی دولتها نیز در رفع آن ناکام هستند.

هر فناوریای که تمایل دارد جامعه را در مقیاس جهانی متحول کند نیز هدف اتهامات قرار میگیرد. به عنوان مثال، انقلاب صنعتی مسلماً بشریت را به سمت بهتر شدن تغییر داد، اما در ابتدا جوامع آن را به دلیل ایجاد بیکاری سرزنش میکردند. وندل والاک (Wendell Wallach)، اخلاقشناس و محققِ دانشگاه ییل، میگوید:

این یک نگرانی قدیمی است ــ مسئلهی افرادِ پیشرفتگریز و مخالفِ فناوری (the Luddite) به 200 سال پیش باز میگردد ــ نگرانی از اینکه هر شکل جدیدی از فناوری، به نسبت مشاغلی که ایجاد میکند، مشاغل بیشتری را از بین میبرد. ما که تا به حال همچین چیزی ندیدهایم. هر فناوری جدید در نهایت مشاغل ثانویهی بیشتری را نسبت به مشاغل حذفشده ایجاد میکند.

اثرات مکانیزاسیون (اتوماسیون) بر اقتصاد به خوبی بررسی شدهاند و این تصورِ عمومی که هوش مصنوعی مشاغل را غارت کرده و به نرخ فزایندهی بیکاری کمک میکند اغراقآمیز به نظر میرسد. در حال حاضر، هوش مصنوعی فقط میتواند کارهای بیش از حد جسمی و یکنواخت را خودکار کند و در کارهایی که به سطوح بالایی از مهارتهای شناختی نیاز دارند، ضعیف عمل میکند.

همانطور که ماروین مینسکی (Marvin Minsky) زمانی اشاره کرد، و احتمالا شما هم به آن فکر کردهاید چرا هیچ ربات مصنوعی هوشمندی با موفقیت برای مهار فاجعه هستهای فوکوشیما مستقر نشد.

بدیهی است که مشاغل آینده پیچیدهتر و از نظر شناختی چالشبرانگیزتر خواهند بود، بنابراین نیاز به آموزش افزایش یافته و منجر به تربیت نیروی کار ماهر میشود. با این حال، اثرات این انتقال بر مشاغل یقه آبی و سفید نگرانکننده است.

راوی شانکار پراساد (Ravi Shankar Prasad)، وزیر الکترونیک و فناوری اطلاعات هند، در مذاکره با شرکتها برای ساختن نقشهی راه یک تریلیون دلاری اقتصاد دیجیتال هند، این امر را موضوعی تکراری دانسته است. او قول میدهد از طریق آموزش پرسنل، هوش مصنوعی قادر است مشاغل بیشتری را ایجاد کند.

استاد معادلات، انسان هیچ!

هانس برلینر (Hans Berliner)، استاد علوم کامپیوترِ دانشگاه کارنگی ملون برنامهای موسوم به BKG 9.8 را نوشت که در سال 1979 با لوئیجی ویلا (قهرمان تختهنرد جهان) بازی کرد و او را شکست داد. این اولین باری بود که قهرمان جهانیِ یک فعالیت فکری شناخته شده توسط یک مصنوع دست بشر در یک آزمون مهارتیِ رودررو شکست میخورد.

گری کاسپاروف ــ استاد بزرگ شطرنج جهان ــ در سال 1997 مغلوب دیپ بلو در IBM شد. لی سدول ــ قهرمان بازی رومیزی چینی Go ــ در سال 2016 به AlphaGo گوگل باخت. و در سال 2017، AlphaGo-Zero (نوعی از AlphaGo) با بازی کردن با خودش بازی گوگل را شکست داد و قهرمان شد. شکست دادن قهرمانان جهان در بازیهایی مانند شطرنج و Go ــ که به طور گستردهای از دید جامعه به عنوان تجسم عقل بشری درک میشوند ــ لزوماً به این معنی نیست که هوش مصنوعی از انسانها باهوشتر شده است.

در حال حاضر، دامنهی تخصص هوش مصنوعی به تعداد انگشتشماری از قابلیتهای کلی محدود شده است به عنوان مثال، یک گاو ممکن است شیر بدهد، اما نمیتواند پرواز با هواپیما را یاد بگیرد. در دفاع از گاو، ممکن است کسی استدلال کند که طبیعتاً برای پرواز با هواپیما مهندسی نشده است. و دقیقاً به همین دلیل است که AlphaGo (طراحی شده برای بازی Go) تا زمانی که بازی شطرنج را یاد نگرفته است، نمی تواند حتی یک کودک نوپا را در شطرنج شکست بدهد (بعد از آن AlphaChess نامیده میشود). هوش مصنوعی کاربردی ممکن است متخصص یک زمینهی خاص را از بین ببرد، اما دقیقا در همان زمینهی تعریفشده و خاص.

اختصاصی بودن این زمینهها، نگرانیهای اخلاقی زیادی را ایجاد میکند:

اگر هوش مصنوعی (در مواردی از انتصابات اشتباه) درک شود، نه تنها ممکن است منجر به نارضایتی (که تا حدودی قابل قبول است) شود، بلکه میتواند به بروز برخی از مشکلات سلامتی هم دامن بزند. همچنین، اگر هوش مصنوعی در یک زمینهی خاص برای انجام یک کار کلی به کار گرفته شود، بسیار محتمل است که به شدت شکست بخورد.

ممکن است هر مشکلی با هوش مصنوعی پیش بیاید؟

شبکههای عصبی دستهای از الگوریتمها هستند که از روش کار مغز الهام گرفتهاند. از شبکههای عصبی به طور گسترده در محصولاتی مانند مترجمها و چتباتها استفاده میشود اگرچه شبکههای عصبی معیارهای عملکردی مخصوص به خود را دارند اما فریب دادن آنها کار سختی نیست. برخی از سیستمها مانند AlphaGo ممکن است عملکرد بهتری از انسانها داشته باشند، اما اکثر آنها یا ضعیف عمل میکنند یا گاهی اوقات از کار میافتند؛ همیشه احتمال خطا وجود دارد. دستیارهای شخصی هوشمند مانند Siri ادعا میکنند که بهرهوری فرد را بهبود میبخشند، اما به طرز وحشتناکی قادر به درک سادهترین عبارات هم نیستند.

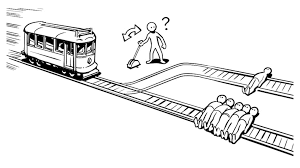

نگرانی دیگر ناشی از کاربرد مستقل هوش مصنوعی در نتیجهی وجود وسایل نقلیهی بدون راننده پدیدار میشود. اگر یک هوش مصنوعی مستقل در وضعیت catch-22 گیر کند چه کاری انجام میدهد؛ در این وضعیت هر عملی منجر به علیت میشود. برای مثال، مسئلهی تراموا (trolley car) را در نظر بگیرید.

آیا هوش مصنوعی در کنترل، اهرم را بر میگرداند؟ اگر بله، چرا؟

و اگر نه، دلیلش چیست؟

ارزش چنین هوش مصنوعیای چه خواهد بود؟ و از آنجایی که تعریف ارزشهای انسانی مبهم است، چگونه میتوان آن را مدلسازی وقابل برنامهریزی کرد؟ این پرسشهای فلسفی و فنی، محققان را ملزم به همکاری و توسعهی راهبردهایی میکند که در آن بشریت با ماشینهای هوشمند همزیستی میکند.

کارشناسان در مورد این که آیا صحبت دربارهی اخلاق در هوش مصنوعی خیلی زود است یا خیر بحث و استدلال میکنند. استیون هاوکینگ، با مصاحبهای که در سال 2014 با بیبیسی انجام داد هیاهویی در جامعهی هوش مصنوعی برانگیخت؛ او هشدار داد که:

توسعهی کامل هوش مصنوعی میتواند به منزلهی پایان نسل بشر باشد.

با این حال، دانشمند معاصر او، میچیو کاکو (Michio Kaku) در مورد چشماندازها چندان غمگین نیست. او انتظار ندارد که به این زودیها یک تَکینگی فناوری (technological singularity) (زمانی که هوش مصنوعی از انسانها باهوشتر میشود) اتفاق بیفتد. کاکو طرفدار تئوری "سوئیچ خاموش" است:

اگر هوش مصنوعی به رفتار نامطلوب خود ادامه دهد، میتوان با خاموش کردن برق آن را متوقف کرد.

این اختلاف عمدتاً ناشی از شکاف در هوش مصنوعی (علم در مقابل مهندسی) است. بنیانگذاران این رشته بیان کردهاند که در جایی در دههی 80، تمرکز این رشته به مهندسی معطوف شد. همانطور که شبکههای عصبی شهرت یافتند، برنامههای کاربردی بیش از حد مورد استفاده قرار گرفتند؛ این منجر به فروش بیش از حد، ناامیدی و رکود تحقیقاتِ باکیفیت هوش مصنوعی شد.

یادگیری عمیق (شبکههای عصبی مدرن) به دلیل اینکه هیچکس نمیداند چگونه الگوریتمها برخلاف رویکردهایی مانند یادگیری بیزی (الگوریتمهای مبتنی بر نظریهی احتمال) کار میکنند، در معرض انتقادات سنگینی هستند. برخی از دانشمندان استدلال میکنند که اگر الگوریتمها غیرقابلحل هستند، یعنی نمیدانند چگونه دارند کاری را انجام میدهند، پس آن را انجام نمیدهند؛ به این ترتیب، آنها مدل مناسبی برای یک مشکل نیستند. حتی اگر این الگوریتمها راهحلی را تولید کنند که امیدوارکننده به نظر برسد، اغلب بهترین راهحل برای مشکل نیست. نوام چامسکی (Noam Chomsky) به طور مداوم چنین مدلهایی را مورد تمسخر قرار داده است، او میگوید:

آیا ماشینها میتوانند مانند پرسیدن فکر کنند، آیا زیردریاییها میتوانند شنا کنند؟ اگر میخواهید اسم آن را شنا بگذارید، خب. آیا هواپیماها پرواز میکنند؟ در انگلیسی، آنها پرواز میکنند، در عبری، آنها سر میخورند.

باربارا پارت (Barbara Parte) دانشمندیست که دیدگاه خود را اینگونه به اشتراک میگذارد:

«دانستن دقیق معناشناسی [مسئله] پیشنیازی هر چیزیست که بتوان آن را هوش نامید».

بحث این است که تحقیقات هوش مصنوعی باید بر نحوهی عملکرد سیستمهای هوشمند و اِعمال آن برای یک مشکل تمرکز کنند. محاسبات کور نه تنها از سوال اصلی دور میشوند، بلکه وضعیت را هم تشدید میکنند.

صنعتی شدن هوش مصنوعی نه تنها برای پیشرفت کلی فناوری در جامعه، بلکه برای اقدامات غیراخلاقی هم پتانسیلهای زیادی دارد. اگرچه افشاگریهای اسنودن در مورد خطر دستیابی به دادهها به حفظ حریم خصوصی کمک کرد، اما ما کماکان به مکیدن دادهها ادامه میدهیم. Big Data (مجموعهی عظیمی از دادهها که به تصمیمگیری کمک میکند) بهانهای برای جمعآوری داده و انجام معاملات ناخواسته شده است.

همچنین میتوان از هوش مصنوعی برای تبدیل جامعه به موش آزمایشگاهی برای آزمایشهای اجتماعی بدون رضایت آگاهانه افراد استفاده کرد. در سال 2014، فیسبوک نتایج تحقیقی را منتشر کرد که در آن، آنها فیدهای خبری را دستکاری کردند تا بررسی کنند که آیا میتوان بر احساسات کاربر تأثیر گذاشت یا خیر. این تحقیق به دلیل استفاده از روشهایی که به کار گرفته شده بودند، با انتقاد شدید دانشگاهیان مواجه شد. هوش مصنوعی Job-recommender گوگل به دلیل ارائهی تبلیغات معتبر فقط به نامزدهای مرد، برچسب جنسیتگرا خورد و هوش مصنوعی به کار رفته در برنامه عکس گوگل، یک فرد سیاهپوست آفریقاییالاصل را به عنوان گوریل شناسایی کرد!

محاسبات انسانی (Crowdsourcing) برای Crpytojacking مورد سوءاستفاده قرار میگیرد: میلیونها وبسایت با تجزیهوتحلیل هوشمندانه و کنترل (تعادل بار) ماشینهای میزبان، ارزهای رمزنگاری شده (مانند بیتکوین) را استخراج کرده و کاربران را با رایانههای کند و تجربهی کاربری ضعیفی روبرو میکنند. ارائهدهندگان خدمات اینترنتی، از ترافیک اینترنت برای کنترل هوشمندانه سرعتها استفاده میکنند و این کار را با شناسایی نوع بار از طریق هوش مصنوعی انجام میدهند. این مسئله توسط درایو Net-Neutrality مورد اعتراض قرار گرفته است.

سلاحهای خودمختار هم از دل تحقیقات دفاعی بیرون آمدند. با این حال، یک فناوریِ احمقانهی بدون «انسانی در وسط» میتواند منجر به فاجعه شود. حادثهی هشدارِ اشتباه هستهای شوروی در سال 1983 را در نظر بگیرید. در 26 سپتامبر، یک سیستم هشدار اولیه در ارتش شوروی گزارش داد که ایالات متحده چندین موشک پرتاب کرده است. استانیسلاو پتروف (Stanislav Petrov)، مرد مسئول، آن را یک هشدار نادرست ارزیابی کرده و از پروتکلهای حملهی تلافیجویانه سرپیچی کرد. یک بررسی تأیید کرد که سیستم هشدار واقعاً خراب شده بود. دخالت انسانی جان میلیونها نفر را نجات داد. عواقب تلافیجویانه (یا حتی نقض امنیتی) میتوانست پایانی بر جهان باشد.

برخی از مسائل در هوش مصنوعی نیازمند توجه فوری هستند، در حالی که برخی دیگر آیندهنگرتر هستند. محققان اغلب در مورد تَکینگی فناوری بحث میکنند و هشدار زمانی را میدهند که هوش مصنوعی از هوش انسانی فراتر میرود. ایدهی تکینگی باعث ناراحتی است، زیرا میتواند چشماندازهایی را به دنیای علمی ــ تخیلی باز کند (به فرانکشتاین فکر کنید).

آیا یک ابرهوش بر بشریت مسلط خواهد شد؟

این هوش مصنوعی نسبت به انسان بدخواه است یا همدل خواهد بود؟

مهندسی یک AGI (Artificial general intelligence) در وهلهی اول یک چالش فناورانه است که همسو کردن آن با ارزشهای انسانی و ایجاد احساسات کاری غیرممکن به نظر میرسد. بنابراین تلاشهای فعلی برای ایجاد یک AGI به دروننگری عمیقی نیاز دارد. حتی اگر نگرانیها در مورد AGI خیلی دور از ذهن به نظر برسند، دیر یا زود باید به آنها رسیدگی کنیم.

با این حال، فراانسانگرایی معاصر، مسائل بیشتری را به دنبال دارد و هدف آن بهبود شرایط انسان، غلبه بر محدودیتهای زیستی و تجربهی خود پس از انسان با استفاده از فناوریهای حال و آینده یعنی مهندسی ژنتیک، هوش مصنوعی و رابط کامپیوتری مغز و غیره است. افراد به صورت بالقوه دارای پتانسیلهای زیادی هستند، اما قرار گرفتن در معرض انگیزههای شیطانی، ممکن است منجر به از بین رفتن تمام اطلاعات شود، ادعایی که توسط نیک بوستروم مطرح شده است.

طوفان فکری اخلاقی:

صنایع و دولتها اخیراً شروع به درک اهمیت اخلاق در هوش مصنوعی کردهاند.

موسسهی «آیندهی زندگی» (FLI) که توسط ماکس تگمارکِ (Max Tegmark) فیزیکدان تأسیس شده است، برای ترویج مشارکت اخلاق در تحقیقات هوش مصنوعی یک جنبش بینالمللی را رهبری میکند. هیئت مشاورهی علمی آن متشکل از ایلان ماسک صنعتگر و دانشمندان برجستهای مانند استیون هاوکینگ (Stephen Hawking)، استوارت راسل (Stuart Russel) و کریستف کخ (Christof Koch) هستند و به دلایل عجیبی، مورگان فریمن (هنرپیشهی آمریکایی) نیز عضو آن است. FLI در سازماندهی کنفرانسهایی در زمینهی هوش مصنوعیِ اخلاقی و تأمین بودجه برای پروژههای تحقیقاتی مرتبط نقش مهمی داشته است. ایلان ماسک اخیراً 10 میلیون دلار برای تحقیقات هوش مصنوعیِ ایمن به این بنیاد اهدا کرده است.

FLI در سال 2017 کنفرانس هوش مصنوعی Asilomar را برگزار کرد که محل تلاقی محققان، فیلسوفان و صنعتگران شد. Ray Kurzweil پیشنهاد کرد همانطور که زمانی برای زیستفناوریها دستورالعملهایی منتشر میشد، در مورد هوش مصنوعی هم باید چنین باشد و به همان نحوی که این دستورالعملها برای زیستفناوریها جواب دادند برای هوش مصنوعی هم باید کار کنند. شین لگ (Shane Legg)، یکی از بنیانگذاران DeepMind، نیاز به درک سازوکارهای داخلی و بازنمایی شبکههای عصبی و الگوریتمهای یادگیری ماشین را مطرح کرد.

شرکتهای دیگری مانند آمازون، فیسبوک، گوگل، دیپ مایند، مایکروسافت و آی بی ام هم مشابه FLI در این بحث هوش مصنوعی مشارکت کردند. ائتلاف چند شرکت غیرانتفاعی با هم با هدف گرد هم آوردن سازمانها، مؤسسات دانشگاهی و شرکتها میتواند منجر به ایجاد هوش مصنوعی برای کمک به مهمترین چالشهای بشر شود.

DeepMind، یک شرکت تحقیقاتی بریتانیانیست که AlphaGo را توسعه داده و Google در ژانویهی 2014 به مبلغ 400 میلیون پوند آن را خریداری نمود. آنها در شرایط کسب اطمینان حاصل کردند که به هیچ تحقیق غیراخلاقی سفارش شده توسط Google متعهد نیستند. این شرکت اخیراً، یک تیم داخلی راهاندازی کرده تا تاثیرات اجتماعی فناوریهایی را که توسعه میدهد بررسی کند، و با «چالشهای اخلاقی کلیدی» مانند حریم خصوصی، شفافیت، حکمرانی و اخلاقیات در میان دیگران مقابله کند. شرکتهایی مانند مایکروسافت و گوگل نیز به تازگی این روند را در داخل خود آغاز کردهاند. آنها در حال ایجاد تیمهای اخلاقی به رهبری دانشمندان و فیلسوفان برتر هستند تا از توسعهی ایمن اطمینان حاصل کنند. یکی از نمایندگان تیم گوگل گفت:

ما نمیخواهیم توسعهی نوآوری را خفه کنیم، اما ارائهی یک ساختارِ نظارتی دقیق روی این سیستمها برای ما و جامعه بسیار مهم است.»

«باز بودن» تاثیر زیادی روی نرمافزارها دارد. کیفیت کار برنامهنویسان را ارتقا میدهد، باگها را شناسایی میکند و کدها را بهبود میبخشد. همچنین کد منبع، علم، دادهها، تکنیکهای ایمنی، قابلیتها و اهداف را در دسترس عموم میگذارد. بنابراین، مطلوبیتِ جهانیِ باز بودن در هوش مصنوعی در حال ظهور است. OpenAI یک شرکت تحقیقاتی غیر انتفاعی هوش مصنوعی (با تامین مالی ایلان ماسک) است که هدف آن ترویج و توسعهی هوش مصنوعیِ دوستانه و توزیع منافع در کل بشریت است.

موسسات آکادمیک بهترین مکان برای معرفی اخلاق هوش مصنوعی هستند، زیرا گرایش اولیه به سمت توسعهی اخلاقی میتواند بخشی از مشکلات را از قبل حل کند. هماکنون دانشگاهها شروع به اضافه کردن مطالعات فلسفه، علوم انسانی و اخلاقی در برنامههای درسی هوش مصنوعی کردهاند. CMU، یکی از رهبران جهانی در تحقیقات یادگیری ماشین، برای ترویج تحقیقات اخلاقی در هوش مصنوعی و رباتیک از بنیاد K & L Gates کمک مالیِ 10 میلیون دلاری دریافت کرد. پروفسور سوبرا سورش، رئیس سابق CMU در سخنرانی خود مطرح کرد:

این تنها فناوری نیست که تعیین میکند این قرن چگونه پیش میرود. آیندهی ما همچنین به شدت تحتتأثیر نحوهی تعامل انسان با فناوری، نحوهی پیشبینی و واکنش ما به عواقب ناخواستهی کارمان، و نحوهی اطمینان از استفاده از فناوری به نفع بشریت، بهصورت فردی و اجتماعی خواهد بود.»

آموزش استفاده از هوش مصنوعی:

همانطور که میدانیم هوش مصنوعی، اینترنت اشیا و سایر فناوریها بشریت را متحول کردهاند. با جمعآوری دادهها و ردیابی فعالیتهای ما، وبسایتها بیشتر از آنچه ممکن است درباره خودمان بدانیم، از ما میدانند. الگوریتمهای ما اثر هنریای را میسازند که خود آن را درک نمیکنند. وسایل نقلیهی کارخانهای مجهز به راهبرهای خودکاری هستند که ممکن است عواقب یک تصمیم را درک نکنند.

هوش مصنوعی در گذشته مسائل بسیاری را برانگیخته است و به این کار ادامه خواهد داد. هدف این است که با درنظر گرفتن اقدامات احتیاطی؛ هوشمندانه بازی کنیم. تحقیقات اخلاقی، اقتصاد و فلسفهی هوش مصنوعی با دروننگری، علم و سرمایهی زیادی همراه است. محققان و صنعتگران شروع به تشخیص نقش مناسب هوش مصنوعی در جامعه کردهاند. با این حال، سیاستهای دولتی هنوز به جایگاه قابلتوجهی نرسیدهاند.

تغییرات آبوهوایی و افزایش جمعیت، پوشش جنگلی ساندربان را به شدت کاهش داده است. در نتیجه، انسانها به محض مواجهه با ببر بنگال مجبور میشوند این حیوانِ در معرض خطر انقراض را بکشند. (قلمرو یک ببر ممکن است 60 تا 100 کیلومتر مربع باشد که اکنون قلمرو او توسط انسان بسیار کوچکتر شده است) وقوع درگیریها اجتنابناپذیر است. این مشکل بسیار اهمیت دارد، اما دلیل اینکه کسی به آن خیلی اهمیت نمیدهد این است که بازده اقتصادی حلِ این مشکل بسیار کم است.

هوش مصنوعی منادی پتانسیلهای عظیم و امکانات بی حد و حصر است، اما برای بهرهبرداریِ کامل از آن دولتها باید از انگیزههای سطحی که صرفا به مقابله با بیکاری محدود میشوند، بپرهیزند. ما باید به طور راهبردی هوش مصنوعی را درون موضوعات مهمتری مانند تغییرات آبوهوایی، مراقبتهای بهداشتی، آموزش، امنیت و تحقیقات مستقر کنیم. پرداختن به مهمترین مسائل در جهان، پتانسیل واقعی هوش مصنوعی را آشکار خواهد کرد. هوش مصنوعی به خودی خود شایستهی احترام یا نفرت نیست. به جای آن، این اراده و اعمال بشریت است که مسیر آیندهی ما را تعیین میکند.

منبع: https://becominghuman.ai/how-ethical-is-artificial-intelligence-37ee034e7435

مقالات مرتبط:

- سند راهنمای «اخلاق در طراحی و اخلاقیات در رویکردهای استفاده برای هوش مصنوعی» کمیسیون اروپا

- نزدیک شدن به هوش مصنوعی اخلاقی: یک دیدگاه خودمانی

- مراحل «عملی» بهکارگیری اصول اخلاق در طراحی و توسعهٔ هوش مصنوعی ــ بخش اول

- مراحل «عملی» بهکارگیری اصول اخلاق در طراحی و توسعهٔ هوش مصنوعی ــ بخش دوم

مراحل «نظری» بهکارگیری «اصول اخلاق در طراحی و توسعهٔ هوش مصنوعی»