Ethics By Design and Ethics of Use Approaches

for Artificial Intelligence

بخش دوم

نحوهٔ بهکارگیری اصول اخلاق در طراحی در توسعهٔ هوش مصنوعی: مراحل عملی

اخلاق در طراحی رویکردی است که میتوان آن را برای اطمینان از اینکه الزامات اخلاقی در طول توسعهٔ سیستم یا تکنیک هوش مصنوعی بهدرستی موردتوجه واقع میشوند، به کار برد. این تنها رویکرد ممکن نیست. با این حال، این رویکرد اختصاصاً طراحیشده تا آنچه را که لازم است تا حد امکان روشن کند، وظایف خاصی را که باید انجام شوند توضیح دهد و به توسعهدهندگان کمک کند در هنگام توسعهٔ یک سیستم هوش مصنوعی دربارهٔ اخلاق بیندیشند.

چرا اخلاق در طراحی؟

برای بسیاری از پروژههای هوش مصنوعی، مسائل اخلاقی مربوطه ممکن است تنها پس از استقرار سیستم شناسایی شوند، در حالیکه برای پروژههای دیگر ممکن است در مرحلهٔ توسعه آشکار شوند. اخلاق در طراحی در وهلهٔ اول برای جلوگیری از بروز مسائل اخلاقی با پرداختن به آنها در مرحلهٔ توسعه، به جای تلاش برای رفع آنها در مراحل بعدی، در نظر گرفته شده است. این امر با استفادهٔ فعالانه از اصول بهعنوان الزامات سیستم حاصل میشود. علاوهبراین، از آنجایی که بسیاری از الزامات تنها در صورت ساختهشدن سیستم به روشهای خاصی محقق میشوند، الزامات اخلاقی گاهی به جای خود سیستم هوش مصنوعی، در فرایندهای توسعه اعمال میشوند.

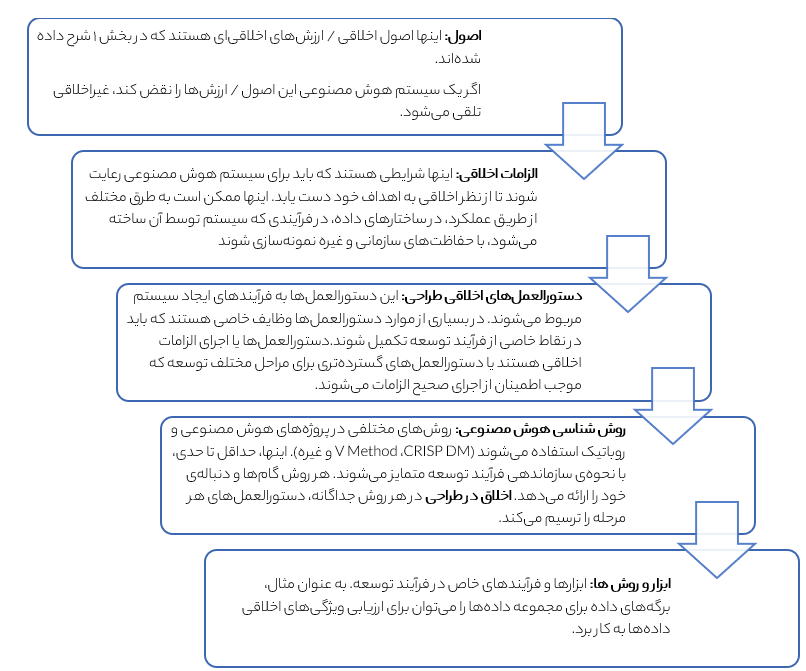

اخلاق در طراحی با یک مدل پنج لایه توصیف میشود؛ این مدل مشابه بسیاری از مدلهای دیگر در علوم کامپیوتر است: سطوح بالاتر انتزاعیتر هستند و با پایین آمدن سطوح ویژگیها زیاد میشوند.

فرایند توسعه

هدف اخلاق در طراحی این است که مردم را در حین توسعهٔ یک سیستم، در خصوص نگرانیهای اخلاقی بالقوه به فکر کردن و ر سیدگی وادارد.

الزامات اخلاقی اصلی برای سیستمهای هوش مصنوعی و رباتیک در بالا را میتوان بهصورت زیر خلاصه کرد:

- سیستمهای هوش مصنوعی نباید بر استقلال، آزادی یا کرامت انسان تأثیر منفی بگذارد.

- سیستمهای هوش مصنوعی نباید حق حفظ حریم خصوصی و حفاظت از دادههای شخصی را نقض کنند. آنها باید از دادههایی استفاده کنند که ضروری، غیرجانبدارانه، نماینده و دقیق هستند.

- سیستمهای هوش مصنوعی باید با دستور کار منصفانه و بدون تبعیض توسعه یابند.

- باید اقدامات لازم را انجام داد تا اطمینان حاصل شود که سیستمهای هوش مصنوعی آسیب فردی، اجتماعی یا زیستمحیطی ایجاد نمیکنند، به فناوریهای مضر متکی نیستند و دیگران را تحتتأثیر قرار نمیدهند تا بهگونهای عمل کنند که باعث آسیب شده یا خودشان بهصورت خزنده عمل کنند.

- سیستمهای هوش مصنوعی باید تا حد امکان برای ذینفعان و کاربران نهایی خود شفاف باشند.

- نظارت و پاسخگویی انسانی برای اطمینان از انطباق با این اصول و رسیدگی به موارد عدم رعایت الزامی است.

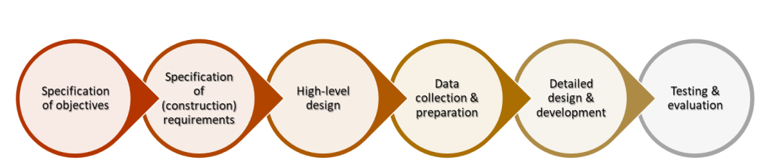

اخلاق در طراحی بر این اساس استوار است که فرایندهای توسعهی سیستمهای هوش مصنوعی و روباتیک را میتوان با استفاده از یک مدل عمومی شش مرحلهای توصیف کرد. این بخش مدل عمومی را تشریح میکند، سپس مراحل موردنیاز برای استفاده از آن را بهمنظور گنجاندن اخلاق در طراحی در فرایند توسعه بیان میکند.

با ترسیم روش توسعهٔ خود طبق مدل عمومی مورد استفاده در اینجا، میتوان الزامات اخلاقی مربوطه را تعیین کرد. پس از انجام این کار، اخلاق در طراحی بهعنوان وظایف، اهداف، محدودیت ها و موارد مشابه در روش توسعه شما گنجانده میشود. بنابراین احتمال بروز نگرانیهای اخلاقی به حداقل میرسد؛ زیرا هر مرحله در فرایند توسعه شامل اقداماتی برای جلوگیری از بروز آنها در وهلهٔ اول است.

با وجود اینکه شش مرحله از مدل عمومی در اینجا در قالب یک لیست ارائه شدهاند، اما اینها لزوما یک فرایند متوالی نیستند. مراحل ممکن است تکراری باشند، مانند مدل V یا CRISP-DM، یا ممکن است از مدلهای آبشاری منحرف شوند و یا اینکه افزایشی باشند، مانند Agile. در هر مورد، تشخیص وظایف مشابه در روش توسعهٔ موردعلاقهٔ شخص، و سپس ترسیم وظایف مدل عمومی بر روی مراحل یا وظایف در رویکرد، نباید دشوار باشند.

شش وظیفه در مدل عمومی عبارتند از:

- مشخص کردن اهداف: تعیین این که سیستم برای چه کاری است و باید قادر به انجام چه کاری باشد.

- تعیین الزامات: توسعهی الزامات فنی و غیرفنی برای ساخت سیستم، از جمله تعیین اولیهٔ منابع موردنیاز، ارزیابی اولیهٔ ریسک و تجزیهوتحلیل هزینه و فایده، که منجر به نقشهٔ طراحی میشود.

- طراحی سطح بالا: توسعهٔ یک معماری سطح بالا. این امر گاهی با توسعهٔ یک مدل مفهومی پیش میرود.

- جمع آوری و آمادهسازی داده: جمع آوری، تأیید، تمیز کردن و یکپارچهسازی دادهها.

- طراحی و توسعهی دقیق: ساخت واقعی یک سیستم کاملاً کارآمد.

- آزمون و ارزیابی: آزمودن و ارزیابی سیستم.

در ادامه هر یک از این مراحل به تفصیل به همراه وظایف مربوطه که برای اطمینان از رعایت اصول اخلاقی انجام میشوند، بررسی میشوند.

1- مشخص کردن اهداف

در این مرحله، اهداف سیستم بر اساس اصول اخلاقی و الزامات ارائهشده در بخش اول ارزیابی میشوند.

نقضهای اخلاقی احتمالی از نظر درجهٔ جدیت متفاوت هستند. برخی از این تخلفها ممکن است فقط فرضی، بسیار بعید یا با جدیت کمتری باشند. در این موارد، لزوماً نباید سیستم را رها کرد، بلکه باید برای جلوگیری از پیامدهای غیراخلاقی و کاهش زودهنگام و بهموقع آنها، اقدامات مشخصی انجام داد.

توجه داشته باشید که برخی از مسائل اخلاقی ممکن است نگرانیهای اخلاقی جدیتری را نسبت به سایرین ایجاد کنند. بهعنوان مثال میتوان این موارد را برشمرد:

- سیستمهایی که حقوق بشر را محدود میکنند؛

- مردم را تحت تسلط خود میگیرند، فریب داده یا دستکاری میکنند؛

- تمامیت جسمی یا ذهنی را نقض میکنند؛

- موجب دلبستگی یا اعتیاد میشوند یا کنترل انسان را بر سر تصمیمهای اصلی شخصی، اخلاقی یا سیاسی سلب میکنند.

برخی از این سیستمها ممکن است طبق قوانین اتحادیهٔ اروپا ممنوع تلقی شوند. از این رو، برخی از اهداف از نقطه نظر اخلاقی تحت هیچ شرایطی مجاز نیستند. اگر هدف یک سیستم اساساً با ارزشها و الزامات اخلاقی ناسازگار باشد، پروژه نباید ادامه یابد. هر کاری که میتواند انجام شود، نباید لزوما انجام شود.

اهدافی که احتمالاً منجر به آسیبهای جسمی، روانی یا مالی به افراد، آسیبهای زیستمحیطی یا آسیب به فرایندها و نهادهای اجتماعی شوند (مثلاً با حمایت از اطلاعات نادرست مردم) نیز از نظر اخلاقی قابلقبول نیستند. اگر پتانسیل قابلتوجهی برای آسیب اجتماعی یا زیستمحیطی ناشی از استفادهٔ فناوری وجود داشته باشد، لازم است که ارزیابی اثرات اجتماعی و/ یا زیستمحیطی انجام شود.

علاوهبراین، در نظر بگیرید که آیا سیستم هوش مصنوعی ــ خود سیستم یا روش استفاده از آن ــ میتواند ناخواسته (یا عمداً) افراد را از نظر اجتماعی یا سیاسی در مضیقه قرار دهد، یا منجر به تبعیض ناعادلانه شود. در این صورت، اهداف سیستم باید اصلاح شده و اقدامات مناسبی برای کاهش این خطرات اتخاذ شوند.

توجه داشته باشید! الزامات اخلاقی در جهت شفافیت، پاسخگویی و نظارت معمولاً در مورد اهداف اعمال نمیشوند، بلکه در مورد معماری و طراحی دقیق سیستم به کار میروند. این الزامات معمولاً باید در این مرحله در نظر گرفته شوند تا مشخص شود که اهداف سیستم تا چه حد اجازه میدهند شفافیت و/ یا مسئولیتپذیری و نظارت لازم در سیستم به کار رود.

توجه: هنگام ارزیابی اهداف، همواره احتمال سوءاستفادهٔ عمدی یا تصادفی را در نظر داشته باشید. تا حد امکان اهداف سیستم را در جهت کاهش چنین احتمالی اصلاح کنید. چنانچه سوءاستفادهٔ بالقوه قابلتوجه است، ارزیابی ریسک را انجام دهید تا خطرات، عناصر طراحی موردنیاز برای کاهش این سوءاستفاده و هر روشی که برای کاهش ریسک پس از استقرار و عملیاتی شدن لازم است، برآورد شوند. |

دو دستورالعمل کلی زیر، برای مرحلهی مشخص کردن اهداف به کار میروند:

- ارزیابی کنید که آیا اهداف پروژهٔ طراحی با الزامات اخلاقی مربوطه مطابقت دارند یا خیر (به بخش ۱ و پیوست ۱ مراجعه کنید). توصیه میشود که یک متخصص اخلاق هوش مصنوعی (در صورت وجود) برای ارزیابی اهداف برای همکاری با اعضای تیم توسعه استخدام شود.

- در هر دو مرحلهٔ تعیین اهداف و تعیین الزامات، ذینفعان خارجی را هم مدنظر قرار دهید. ممکن است ذینفعان از مسائل اخلاقی گستردهتری که در نتیجهٔ استفاده از سیستم ناشی میشوند، آگاه باشند. در صورت امکان، باید با ذینفعان در مورد اینکه چه مسائل اخلاقیای در معرض خطر هستند و چگونگی برخورد با این مسائل مشورت کرد. ذینفعان باید بهطور مناسبی متنوع باشند (جنس، سن، قومیت، و غیره) و گروههای عمدهای را شامل شوند که بهطور مستقیم یا غیرمستقیم تحتتأثیر سیستم قرار می گیرند. به این ترتیب طیف متنوعی از ایدهها و ترجیحات به انتخاب طراحی کمک خواهند کرد

2- تعیین الزامات فنی و غیرفنی

در طول این مرحله، الزامات توسعه، منابع و برنامهها بر اساس الزامات اخلاقی ارزیابی میشوند.

کارکرد اولیهٔ مرحلهٔ تعیین الزامات، رسیدن به برنامهی توسعهایست که شامل مشخصات طراحی سیستم، تعریف زیرساخت توسعه، تعیین منابع کارکنان موردنیاز، تعیین نقاط عطف و سایر مهلتها و غیره است.

اکثر سازمانها دارای مجموعهٔ استانداردی از ابزارهای توسعه هستند که برای همهٔ پروژهها استفاده میشوند. ساختارها و رویههای سازمانی و مدیریتی ــ به مانند روششناسی توسعه ــ معمولاً با این ابزارها تنظیم میشوند. بااینوجود، نمیتوان فرض کرد که هر ابزار، فرایند یا عنصر سازمانی از اخلاق در طراحی پشتیبانی میکند. برخی از الزامات اخلاقی مشکلات جدیدی را در طول توسعه ایجاد میکنند. برای مثال، دیگر صرف اصلاح مجموعه دادهها برای سوگیری کافی نیست، بلکه توسعهدهندگان باید مستند کنند که این کار چگونه انجام شده است. در نتیجه، الزامات مربوط به نظارت و حسابرسی انسانی ممکن است نیاز به مستندسازی بسیاری از فرایندهای داخلی را به میزانی بیشتر از آنچه قبلاً وجود داشته، تحمیل کند. بنابراین باید در نظر گرفت که ابزارها و ساختارهای سازمانی مورداستفاده در پروژههای که قبلاً بر روشهای توسعه متکی بودند، ممکن است نیاز به اصلاح داشته باشند.

در برخی موارد، ابزارهای توسعهی مناسبی که امکان برآوردن الزامات اخلاقی را فراهم کنند، ممکن است به آسانی دردسترس نباشند. با این حال، لازم است که در جستجوی ابزار مناسب بسیار دقیق بود. الزامات تعیینشده در اینجا منحصر به Horizon Europe نیستند، بلکه خواستههای رایج بسیاری از پروژههای هوش مصنوعی هستند. درنتیجه، ابزارهای لازم برای برآوردن الزامات اخلاقی مربوطه به سرعت در حال توسعه هستند.

همهی الزامات اخلاقی ممکن است مرتبط نباشند! درجهای که ناتوانی فنی در برآوردن یک الزام اخلاقی می تواند مانع از پیشبرد پروژه شود، به الزامات اخلاقی خاص موردنظر و عملکرد سیستم بستگی دارد. بهعنوان مثال، سیستمی که وامهای شخصی را تأیید میکند باید بتواند هر تصمیم فردی را در قالبی خوانا برای انسان توضیح دهد، زیرا افراد تحتتأثیر تصمیمات آن قرار میگیرند. در مقابل، سیستمی که قرار ملاقاتها را مدیریت میکند ممکن است تنها تأثیر محدودی بر زندگی افراد داشته باشد، بنابراین به شفافیت کمتری نیاز دارد. در مواردی که اعتقاد بر این است که برآوردن یک الزام اخلاقی مربوطه از نظر فنی غیرممکن است، اهمیت این الزام عاملی در تعیین تأیید خواهد بود. |

دستورالعملهای کلی زیر تا حدی که با نوع تحقیق پیشنهادی مطابقت داشته باشند (از پایه تا پیشرقابتی)، برای مرحلهی تعیین الزامات اعمال میشوند:

- مشخصات طراحی پیشنهادی، محدودیتها، منابع انتخابشده و زیرساختها باید از نظر سازگاری با الزامات اخلاقی ارزیابی شوند. مثلاً، برخی از تکنیکهای یادگیری عمیق ممکن است برای شفافیت انتخاب خوبی نباشند. مناسب است که این مشخصات و محدودیتها را در برابر الزامات اخلاقی قسمت ۱ بررسی کنید و درصورت لزوم برای اطمینان از تناسب، آنها را اصلاح کنید.

- هنگامی که برنامهٔ یک طراحیِ کامل تولید شد (و تا حدودی با نوع پژوهش پیشنهادی مطابقت داشت)، بهمنظور برآورد خطرات اخلاقی خاص در توسعه، استقرار و استفاده از سیستم، یک ارزیابی تاثیرات و ریسک اخلاقی توصیه میشود که باید شامل ارزیابی خطرات مرتبط با استفادههای ناخواسته و پیامدهای سیستم باشد. برای جلوگیری از خطرات یا کاهش خطرات اجتنابناپذیر باید برنامهریزیهایی صورت گیرد. این ارزیابی ریسک باید در مراحل منظم فرایند توسعه، از طریق دسترسی بیشتر اطلاعات بهروز شود. نیاز است که برای ارزیابی ریسک اخلاقی برنامهریزی و بودجهبندی شود. توصیه میشود که در صورت امکان، این کار توسط یک متخصص اخلاق با سابقهٔ حرفهای مناسب انجام شود. ارزیابی باید بر اساس ماهیت پروژه، شدت خطرات اخلاقی و بودجهٔ کلی برای توسعهی پروژه مقیاس شود.

- توصیه میشود که در این مرحله یک طرح پیادهسازی اخلاق در طراحی (EbD) تهیه شود که در آن تمام گامهای بعدی موردنیاز برای گنجاندن EbD در فرایند توسعه، مشخص شده و بازیگران مسئول در انجام و نظارت بر وظایف تعیین شوند. در صورت لزوم، این طرح اجرایی باید ریسک اخلاقی و ارزیابی تأثیر را در صورتی که تکمیل شده باشد، در بر بگیرد.

- علاوهبراین، توصیه میشود که ارزیابی شامل یک معماری انطباق اخلاقی در زیرساخت توسعه و مجموعهٔ ساختارها و رویههای سازمانی هم باشد. این معماریِ انطباق اخلاقی باید بر ابزارها و فرایندها در سطح توسعهدهنده تمرکز کند، اما به مکانیسمهایی برای ارتباطات خارجی از سوی کاربران نهایی و سایر ذینفعان در طول آزمایش و ارزیابی هم نیاز دارد. یک راه سادهٔ رو به جلو این است که معماری انطباق اخلاقی را با انطباق قانونی مرتبط کنیم.

توصیه میشود که ارزیابی، یک مدل حاکمیت اخلاقی که ساختارهای سازمانی برای ادارهٔ فرایند EbD (مثلاً کمیتههای بررسی اخلاقی/ مشاور اخلاقی/ حسابرس اخلاقی) را در بر میگیرد، در خود داشته باشد.

3- طراحی سطح بالا

طراحی سطح بالا به توسعهٔ معماری کلی سیستم مربوط میشود.

الزامات اخلاقی باید دقیقاً مانند سایر الزامات سیستم در نظر گرفته شوند. طراحی باید شامل عملکردی باشد که به وسیله آن از الزامات اخلاقی بهصورت برنامهریزیشده حمایت شود، مانند نگهداری گزارشهای دستکاری دادههای داخلی توسط سیستم. الزامات شفافیت و نظارت انسانی معمولاً به ویژگیهایی فراتر از آنچه برای دستیابی به هدف سیستم موردنیاز است، احتیاج دارد.

دستورالعملهای کلی زیر برای مرحلهٔ طراحی سطح بالا، تا حدی که با نوع پژوهش پیشنهادی (از پایه تا پیشرقابتی) مطابقت داشته باشند و هر زمان که قابلاجرا باشد اعمال میگردند:

- بررسی کنید که آیا طراحی به یک رابط مبتنی بر اصول طراحی انسانمحور ــ که فرصتهای معناداری را برای انتخاب انسان ایجاد میکنند ــ مجالی میدهد یا خیر.

- ویژگیها و عملکردهایی را طراحی کنید که موجب میشوند قابلیتها و اهداف سیستم بهطور آشکار به کاربران و هر کسی که ممکن است تحتتأثیر آن قرار گیرد، منتقل شوند.

- مکانیسمهایی را طراحی کنید تا مردم بدانند چه زمانی در معرض تصمیمات سیستم قرار میگیرند. این مکانیزمها میتوانند رویههای عملیاتی مورداستفاده پس از استقرار هم باشند.

- مطمئن شوید که بعد از استقرار سیستم، هیچ جنبهای از سیستم هوش مصنوعی که ممکن است بدون اطلاع قبلی، با یک انسان اشتباه گرفته شود، وجود نداشته باشد. به خاطر داشته باشید که بسیاری از افراد ممکن است درک درستی از هوش مصنوعی نداشته باشند و ناآگاهانه تصور کنند که با یک فرد در حال تعامل هستند. برای مثال، حتی زمانی که در مورد چتباتها این مورد رعایت شود، افرادی که نمیدانند اصطلاح چتبات به چه معناست، ممکن است آن را با انسان اشتباه بگیرند.

- بررسی کنید که طراحی از الزامات اخلاقی برای حفظ حریم خصوصی، حفاظت از دادههای شخصی، و حاکمیت داده پشتیبانی میکند. اطمینان حاصل کنید که فرایندها، رویهها و ابزارهای توسعه، دادههای شخصی را بهگونهای که حقوق اساسی افراد را نقض کند، در معرض نمایش قرار نمیدهند. برای مثال، گزارشهای خطا ممکن است شامل دادههای شخصیای باشند که هنگام مواجهه با یک باگ به آنها دسترسی پیدا میکنند. به ویژه مهم است که اطمینان حاصل شود که توسعهدهندگان به اطلاعات شخصی قابلشناسایی دسترسی ندارند؛ مگر در موارد کاملاً ضروری و دستورالعملهای منطبق با GDPR.

- یک فرایند رسمی را برای تضمین انتخاب دادهها برای یک سیستم منصفانه، دقیق و بیطرفانه وضع نمایید. برای ارزیابی اولیهٔ منابع داده قبل از وارد شدن به سیستم، برنامهریزی کنید. یک مکانیسم قابلبازبینی را طراحی کنید که نحوهی انتخاب داده، جمعآوری، ذخیره و استفاده از دادهها را ثبت کند (هم فرایند توسعه و هم استفاده پس از عملیاتیشدن را پوشش دهد). نمیتوان فرض کرد که دادههای به دست آمده همان دادههای موردنظر هستند. برای مثال، مجموعهٔ دادهها ممکن است ناقص باشند یا روشهای وارد کردن دادهها ممکن است آنها را به روشهای غیرمنتظرهای تغییر دهند. این مورد شامل فرایندهای رسمی طراحی برای بررسی و تصحیح سوگیری یا خطاها پس از وارد کردن هر داده هم میشود.

- ارزیابی کنید که آیا این سیستم میتواند هرگونه آسیب فیزیکی به افراد، حیوانات، اموال یا محیطزیست وارد کند یا خیر. اگر این امکان وجود دارد، ویژگیهای طراحی را برای به حداقل رساندن خطر و/ یا شیوع و شدت آسیب احتمالی بگنجانید (بهعنوان مثال اگر سیستم میتواند به دستورات صوتی پاسخ دهد، باید دستورات صوتی «ایست اضطراری» را در طراحی بگنجانید).

- تمام تأثیرات منفی احتمالی بر گروههای مربوطه را در نظر بگیرید، ازجمله تأثیراتی غیر از آنهایی که ناشی از سوگیری الگوریتمی یا عدم دسترسی جهانی است و اقداماتی را برای کاهش هرگونه تأثیر منفی بالقوه (مانند انگ زدن، تبعیض) طراحی کنید.

- سیستمهای هوش مصنوعی مرتبط با رسانهها، ارتباطات، سیاست، تحلیلهای اجتماعی و جوامع آنلاین باید از نظر پتانسیل تأثیر منفی بر کیفیت ارتباطات، تعامل اجتماعی، اطلاعات، فرایندهای دموکراتیک و روابط اجتماعی ارزیابی شوند. در صورت لزوم، پیشنهادهای پژوهشی باید اقدامات کاهشی برای کم کردن خطر چنین آسیبهایی را به تفصیل شرح دهند.

- هر زمان که مرتبط باشد، باید تأثیرات زیستمحیطی سیستم را در نظر بگیرید و در صورت نیاز اقداماتی را برای کاهش اثرات منفی انجام دهید. در مرحلهٔ تعیین اهداف، باید یک ارزیابی اولیهٔ زیستمحیطی انجام شود. بعد از تکمیل طراحی سطح بالای سیستم، این ارزیابی باید به تفصیل انجام شود تا نشان دهد که چگونه سیستم به روشی سازگار با محیطزیست ساخته خواهد شد.

- در صورت لزوم، در نظر گرفتن تأثیر احتمالی بر ایمنی و مطابقت با استانداردهای مناسب مانند IEEE P1228 (استاندارد ایمنی نرمافزار) را نمایش دهید و آنها را در ویژگیهای طراحی لحاظ کنید تا از ایمنی و انطباق، مطمئن شوید.

- در نظر داشته باشید که چگونه تصمیمات سیستم برای کاربران و سایر ذینفعان قابلتوضیح هستند. در صورت امکان این توضیح باید شامل دلایلی باشد که چرا سیستم تصمیم خاصی گرفته است. سیستم (یا کسانی که آن را مستقر میکنند) همیشه باید مکانیزمی داشته باشد که بهوسیلهٔ آن توضیح دهد که تصمیم چه بوده و از چه دادهها / ویژگیهایی برای تصمیمگیری استفاده شده است. توضیحپذیری بهویژه با سیستمهایی که تصمیم میگیرند، توصیه میکنند، یا اقداماتی را انجام میدهند که ممکن است آسیب قابلتوجهی ایجاد کنند، بر حقوق فردی تأثیر بگذارند، یا بر منافع فردی یا جمعی تأثیر زیادی بگذارند، مرتبط است.

- روشهایی را طراحی و ابزارهایی را انتخاب و پیکربندی کنید که بتوانند فرایندهای توسعه را بهگونهای مستند کنند که افراد بتوانند تصمیمات فرایندهای طراحی و توسعه را درک و ارزیابی کنند. پیشنهادهای پژوهشی همچنین باید توضیح دهند که انسانها چگونه قادر خواهند بود تصمیمات سیستم را درک کنند و چه مکانیسمهایی برای نادیده گرفتن آنها توسط انسان طراحی خواهد شد. برای این مستندات یک رویکرد لایهای که طیف وسیعی از جزئیات فنی را ارائه میکند، توصیه میشود. این رویکرد از مرورهای اولیه، مانند خلاصههای اجرایی، آغاز میشود و طرحوارههای دقیق و سایر مدلهای فنی را دربر میگیرد. به این ترتیب، میتوان اسنادی متناسب با سطح تخصص و دغدغههای خاص افراد را در اختیار آنها نهاد.

- مطمئن شوید که طراحی شامل مکانیسمهایی است که سیستم هوش مصنوعی تصمیمات خود را بهوسیله آنها ثبت میکند تا بتوانند در معرض بازبینی و پاسخگویی انسانی قرار گیرند. اگر سوژههای داده یا کاربران، نهایی رفتار سیستم را زیر سوال ببرند، این بررسی بهعنوان بخشی از بررسی حاکمیت اخلاقی داخلی یا ممیزی خارجی، میتواند از طریق ممیزی پس از استقرار صورت گیرد.

- تا حد امکان و متناسب، سازوکارهایی برای پاسخگویی، نظارت انسانی و ممیزی خارجی پس از استقرار طراحی کنید. این سازوکارها ممکن است به عملکرد اضافهای در داخل سیستم، تنها برای گزارش فعالیتهای داخلی که هیچ نقشی در عملکرد سیستم ندارند نیاز داشته باشند. مکانیسمهای نظارت پس از استقرار باید به کارهای نظارتی انجامشده در طول توسعه دسترسی داشته باشند.

- در طراحی یک سیستم اخلاقی برای مستندات، اطمینان حاصل کنید که برای شناسایی مسائل اخلاقی و حل آنها؛ قابلردیابی و دارای توضیح کافی باشند.

- یک رژیم آزمایشی را در طراحی بگنجانید که بتواند بررسی کند که آیا عملیات داخلی سیستم با الزامات اخلاقی مطابقت دارد یا خیر. این رژیم ممکن است به تغییراتی در نحوهٔ دستیابی به عملکرد در سیستم نیاز داشته باشد تا امکان آزمایش و اقدامات اصلاحی مناسب را فراهم آورد. پیشنهاد پژوهشی باید جزئیاتی دربارهٔ چگونگی شناسایی، توقف و جلوگیری از تکرار مجدد اثرات نامطلوب اخلاقی و اجتماعی سیستم ارائه کند.

- در صورت امکان و ارتباط، اطمینان حاصل کنید که آیا فرایندی وجود دارد که از طریق آن هم کارکنان داخلی و هم اشخاص ثالث بتوانند آسیبپذیریها، خطرات یا سوگیریهای احتمالی سیستم را، هم در طول فرایند توسعه و هم پس از استقرار گزارش کنند یا خیر.

- مطمئن شوید که سیستم بهگونهای طراحی شده است که امکان حسابرسی اخلاقی خارجی را فراهم میکند تا از وجود پاسخگویی اطمینان حاصل شود. اگر مطمئن نیستید، از روشهای حسابرسی اخلاقی موجود کمک بگیرید.

- ویژگیها و عملکردها را بهگونهای طراحی کنید که کاربران نهایی از قابلیتها و محدودیتهای سیستم هوش مصنوعی پس از استقرار نیز آگاه باشند تا از مسائل مربوط به انحراف عملکرد، اتوماسیون یا تعصبات تعبیر و ترجمه ها جلوگیری شود.

- اطمینان حاصل کنید که توسعهدهندگان برای توسعهٔ آگاهی و شیوههای پاسخگویی آتی (از جمله دانش مرتبط با چارچوب قانونی قابلاجرا در سیستم) آموزش کافی دیدهاند.

علاوهبراین، پیشنهادات پژوهشی برای توضیح اینکه چگونه طراحی با قابلیت دسترسی جهانی سازگار است، تشویق میشوند؛ (مانند نشان دادن انطباق با دستورالعملهای دسترسی مرتبط).

این توضیح میتواند شامل ارزیابی دسترسی رابط و سایر نقاط تماس باشد. بررسی طراحی رابط اولیه و سایر نقاط تماس نشان خواهد داد که آیا یک رویکرد به یکاندازه برای همهٔ کاربران اعمال میشود یا خیر. در این صورت، ممکن است لازم باشد طرح را اصلاح کنید یا یک توجیه رسمی برای آن تهیه کنید.

4- جمعآوری و آماده سازی داده

جمعآوری و آمادهسازی دادهها از نظر اخلاقی یک مرحلهٔ بسیار مهم است.

باید فرض شود که هر دادهٔ جمع آوریشده مغرضانه، انحرافی یا ناقص است تا زمانی که خلاف آن ثابت شود. انصاف و دقت دغدغههای اصلی در اینجا هستند. بهطور کلی، دادههای جمعآوریشده از فعالیتهای انسانی در هر جامعه، مانند ارتباطات نوشتاری یا الگوهای شغلی، ممکن است منعکسکنندهٔ سوگیریهای آن جامعه باشند. بنابراین باید بهطور فعال نشان داده شود که دادهها قبل از اینکه بتوان به آنها اعتماد کرد، دقیق، معرف یا خنثی هستند.

علاوهبراین، آمادهسازی دادهها ممکن است به مسائل اخلاقی نیز منجر شوند. گامهایی باید برداشته شود تا اطمینان حاصل شود که یادگیری آزمایشی و/ یا دستکاری الگوریتمی سوگیریهای جدیدی ایجاد نمیکنند یا منجر به مسائل اخلاقی دیگر (مانند بینامسازی) نمیشوند. مشکلات اغلب در مواردی ایجاد میشوند که آزمایش بهطور دقیق، استفاده در دنیای واقعی را پس از استقرار منعکس نمیکنند، مانند ایجاد اتوماسیون یا سوگیریهای ترجمهای. بهعنوان مثال، بسیاری از سیستمهای تشخیص چهره به دلیل آزمایش روی جمعیتهای قفقازی، عملکرد ضعیفی نسبت به افراد با پوست تیرهتر دارند.

به خاطر داشته باشید که هنگام پردازش دادههای شخصی، تمام تحقیقاتی که توسط اتحادیهٔ اروپا تأمین مالی میشوند، باید با قوانین بینالمللی، اروپایی و ملی و با بالاترین استانداردهای اخلاقی مطابقت داشته باشند. این بدان معناست که ذینفعان اتحادیهٔ اروپا باید اصول GDPR را اعمال کنند مگر اینکه به استانداردهای بالاتر حفاظت از دادهها ملزم باشند. اگر از سازمانها/ ارائهدهندگان خدمات خارجی برای ذخیرهسازی / تحلیل / جمعآوری دادهها استفاده میکنید، مطمئن شوید که این موارد نیز با الزامات حفاظت از دادهها مطابقت دارند. |

تا حدی که با نوع پژوهش پیشنهادی (از پایه تا پیشرقابتی) مطابقت داشته باشد و هر زمان که قابلاجرا باشد، دستورالعملهای کلی زیر برای مرحلهی جمعآوری و آمادهسازی دادهها اعمال میشوند:

- ارزیابی کنید که چگونه عملیات در هر فرایند ممکن است الزامات اخلاقی و/ یا حفاظت از دادهها را نقض کنند. تغییرات لازم را به دنبال آن ایجاد کنید. اگر تغییرات مناسب امکان پذیر نباشند، ممکن است نیاز به تغییر اهداف طراحی باشد.

- اطمینان حاصل کنید که پردازش دادههای شخصی با مقررات حفاظت از دادههای عمومی (GDPR) و سایر قوانین ملی و اتحادیهٔ اروپا مطابقت دارد. یک خط مشی حفاظت از دادههای خاص تهیه کنید که جزئیات نحوهٔ انطباق پروژه با الزامات حفاظت از دادهها را شرح دهد. اکیداً توصیه میشود با افسر حفاظت از دادههای خود یا فردی با تخصص مربوط به حفاظت از دادهها (در صورت وجود) مشورت کنید. توجه داشته باشید که هر زمان که سیستم شما در حال پردازش دادههای شخصی است، باید از اصل کمینهسازی دادهها پیروی کند. این بدان معناست که شما باید اطمینان حاصل کنید که فقط دادههایی که مرتبط، کافی و محدود به آنچه کاملاً ضروری هستند، توسط سیستم شما پردازش میشوند. شما همچنین باید اصول حفاظت از دادهها را به طور پیشفرض رعایت کنید و از حقوق و آزادیهای افراد موضوع داده محافظت کنید.

- مراحلی را مشخص کنید تا مطمئن شوید که دادههای مربوط به افراد معرف هستند و تنوع آنها را منعکس میکنند یا به اندازهٔ کافی خنثی هستند. به طور مشابه، شما باید نحوهٔ جلوگیری از خطاها در دادههای ورودی و طراحی الگوریتمی که میتواند گروههای خاصی از افراد را نادرست یا ناعادلانه نشان دهد، مستند کنید.

- مطمئن شوید که دادههای ورودی، آموزشی و خروجی همگی برای سوگیری ورودی (سوگیری در دادههایی که منجر به نمایش ناعادلانه، غیرنماینده یا تعصبآمیز افراد و گروهها میشوند) تجزیهوتحلیل میشوند. بهویژه، تا حد امکان تأیید کنید که دادههای شخصی و گروهی توضیحدهندهٔ تنوع در جنسیت، نژاد، سن، گرایش جنسی، منشأ ملی، مذهب، سلامت و ناتوانی و سایر مقولههای اجتماعی مرتبط با این وظیفه هستند و فرضیات تعصبآمیز، کلیشهای یا تبعیضآمیز دیگر در مورد افراد در این دستهها قرار نمیگیرند. در جایی که مشخص شود سوگیری امکان پذیر است، مکانیسمهایی را برای اجتناب یا اصلاح آن ایجاد کنید. یعنی معیارهایی که براساس آن دادهها انتخاب میشوند را اصلاح کنید یا بهگونهآی برنامهریزی کنید که مجموعهی دادهها پس از قرار گرفتن در سیستم اصلاح شوند. الزامات شفافیت و نظارت مستلزم مستند بودن چنین اصلاحاتی هستند.

- دادههای آموزشی خود را تجزیهوتحلیل کنید و اطمینان حاصل کنید که مرتبط و نماینده هستند. ارزیابی سوگیری را بهطور رسمی برای دادههای واردشده به سیستم انجام دهید. فرض نکنید که دادههای وارد شده به سیستم بیطرفانه هستند؛ آنها را تا حد امکان با توجه به خطرات ناشی از هوش مصنوعی پیشبینیشده برای حقوق و آزادیهای اساسی آزمایش کنید. تنوع و نمایندگی کاربران در دادهها، آزمایش برای جمعیتهای خاص یا موارد استفادهی مشکلساز را بسنجید. مطمئن شوید که دادههای یک گروه جمعیتی برای نشان دادن دیگری استفاده نمیشود، مگر اینکه بهطور موجهی نماینده باشند. پتانسیل سوگیری مضری را که در مرحلهٔ آمادهسازی دادهها معرفی میشوند، ارزیابی کنید، مانند حذف ناخواستهٔ دادههای مربوط به یک گروه اقلیت. اقداماتی را برای کاهش چنین خطری انجام دهید. مطمئن شوید که در صورت امکان، توانایی بازگشت به هر حالتی که سیستم در آن بوده است وجود داشته باشد تا مشخص یا پیشبینی شود که سیستم در زمان x چه کاری انجام میداد و در صورت امکان، تعیین کنید که از کدام دادهٔ آموزشی استفاده شده است.

- اطمینان حاصل کنید که کارکنان درگیر، در مورد چارچوب قانونی قابلاجرا و نگرانیهای اخلاقی آموزش مناسبی دیدهاند.

منبع: کمیسیون اروپا مدیریت کل پژوهش و نوآوری ــ بخش اخلاق و یکپارچگی تحقیقات

مترجم: مریم رضائی حاجیده

مقالات مرتبط:

- سند راهنمای «اخلاق در طراحی و اخلاقیات در رویکردهای استفاده برای هوش مصنوعی» کمیسیون اروپا

- مراحل «عملی» بهکارگیری اصول اخلاق در طراحی و توسعهٔ هوش مصنوعی ــ بخش دوم

- نزدیک شدن به هوش مصنوعی اخلاقی: یک دیدگاه خودمانی

- هوش مصنوعی چقدر اخلاقی است؟

- ایجاد یک رویکرد سازمانی برای هوش مصنوعی مسئول

- مراحل «نظری» بهکارگیری «اصول اخلاق در طراحی و توسعهٔ هوش مصنوعی»